Data warehouse: l'analisi dei dati nei processi aziendali

I sistemi di supporto decisionale hanno una lunga tradizione nel mondo degli affari. Già dagli anni '60 le aziende utilizzano metodi di analisi per ottenere dati che servano a supportare il management con report, modelli e previsioni e che siano quindi strategicamente rilevanti per i processi aziendali.

I sistemi informativi coinvolti incorporano concetti come quelli di MIS (Management Information System), DSS (Decision Support Systems) ed EIS (Executive Information System). Poiché si tratta di processi difficili da distinguere l'uno dall'altro, a partire dagli anni '90 sono stati raggruppati sotto il termine generale di Business Intelligence (BI) nell'ambito operativo e della commercializzazione dei prodotti.

Business Intelligence (BI) è un termine generale per la preparazione e l'analisi dei dati grezzi con il supporto dell'information technology. La BI serve per produrre conoscenze utili sulle quali basare le decisioni in materia di strategia aziendale.

Oggi la base di dati necessaria alla tecnologia BI per assistere nel processo di decisione viene solitamente messa a disposizione da un magazzino centrale, chiamato data warehouse. Di seguito vi presentiamo i concetti fondamentali del data warehousing, mostrando l'architettura di tale sistema informativo e presentando i provider più affermati di soluzioni DWH commerciali e qualche alternativa open source gratuita.

Che cos'è un data warehouse?

Un data warehouse (DWH), che si può tradurre in italiano con "magazzino di dati", è un sistema di database indipendente dai sistemi operativi di elaborazione dati in cui vengono raccolti, compressi e archiviati dati storici provenienti da fonti diverse ed eterogenee. Molte aziende trasferiscono regolarmente i dati archiviati dai sistemi operativi in questi magazzini con lo scopo di tenerli pronti per eventuali successive analisi strategiche nell'ambito della Business Intelligence (BI).

- Dati operativi: i dati operativi sono informazioni transazionali generate dai sistemi amministrativi e contabili nel corso delle attività quotidiane delle aziende. Le fonti tipiche di questi dati sono i sistemi operativi come i programmi contabili e di gestione merci, l'Enterprise resource planning (ERP, in italiano "pianificazione delle risorse d'impresa"), i sistemi informativi aziendali e i software di ordinazione.

- Dati pianificati: i dati pianificati sono i dati operativi ottenuti in seguito al processo di raccolta, archiviazione e organizzazione per l'analisi.

Un DWH offre agli analisti una visione completa di dati eterogenei e consente l'aggregazione di numeri operativi chiave nel campo dell'On-Line Analytical Processing (OLAP), fungendo da punto di raccolta centrale di tutti i dati che servono al knowledge management. Di norma agli utenti viene autorizzato l'accesso in sola lettura. Un magazzino di dati funziona inoltre come base per il data mining e come riferimento per tutte le considerazioni di gestione della performance e di orientamento strategico dell'impresa.

L'architettura di un data warehouse

Il processo di gestione e valutazione dei dati da parte di un DWH si chiama data warehousing e comprende le seguenti fasi:

- Acquisizione e integrazione dei dati

- Archiviazione dei dati

- Valutazione e analisi dei dati

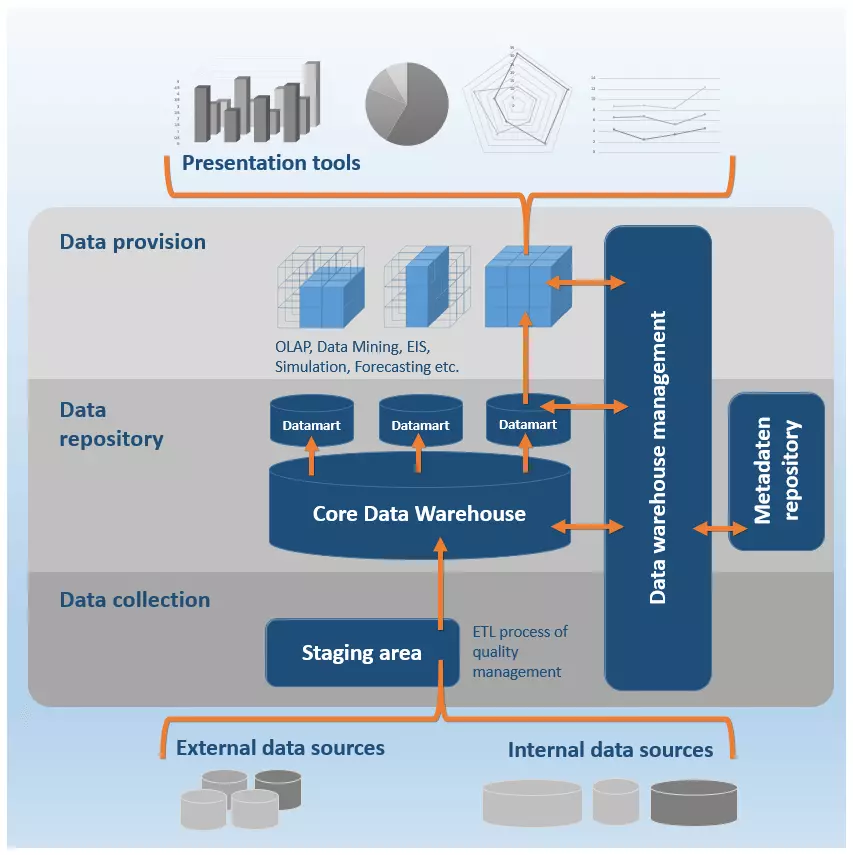

Le fasi del data warehousing si riflettono nella struttura ideale dei sistemi di data warehouse, la cosiddetta architettura di riferimento. Sebbene questa possa differire a seconda del software e dello sviluppatore, la struttura tecnica si basa sostanzialmente su un modello modulare che si può suddividere in tre livelli:

- Livello di acquisizione dei dati

- Livello di archiviazione dei dati

- Livello di presentazione dei dati

È presente inoltre una componente di controllo centrale: il data warehouse manager, che assegna funzioni speciali di amministrazione a ogni livello del DWH. È importante notare che i singoli componenti di un data warehouse non devono necessariamente provenire da un unico fornitore.

Il grafico che segue rappresenta schematicamente l'architettura di riferimento di un DWH:

Acquisizione dei dati

Prima di caricare i dati nel DWH, è necessario codificarli in modo uniforme. Un data warehouse si alimenta dei dati provenienti sia da fonti interne all'azienda sia da fonti esterne:

- Dati interni: sistemi di Enterprise resource planning (ERP), Customer relationship management (CRM) e Content management (CMS), banche dati operative, flat file (es. Excel, CSV, file di testo), e-mail, etc.

- Dati esterni: applicazioni e sistemi di fornitori esterni, siti web/Internet, social media, servizi cloud, etc.

I sistemi a livello di data entry forniscono interfacce per i sistemi operativi aziendali e vengono utilizzati nella prima fase di immagazzinamento dei dati: le funzioni principali di questo componente del DWH sono l'acquisizione e l'integrazione dei dati.

Per la raccolta dei dati si utilizzano le seguenti tecniche di estrazione:

- Trigger: nel caso in cui i sistemi operativi aziendali supportino trigger di database, questi possono essere utilizzati per automatizzare l'estrazione dei dati. I trigger consentono di definire le operazioni che verranno eseguite automaticamente al verificarsi di determinati eventi. Gli eventi scatenanti sono solitamente i cambiamenti nel set di dati dei sistemi sorgente che portano all'estrazione dei dati modificati nel DWH.

- File di registro: se un sistema operativo non supporta la tecnologia trigger, il livello di acquisizione dati di un DWH può contenere programmi in grado di valutare i file di registro (log) dei sistemi sorgente ed estrarre le operazioni in esso registrate.

- Programmi di monitoraggio: se per l'estrazione non sono disponibili né trigger né file di registro, vengono di solito impiegati programmi di monitoraggio. Questi estraggono i cambiamenti nel set di dati di un sistema operativo utilizzando algoritmi che generano istantanee dei dati da monitorare a intervalli regolari e li confrontano con quelli precedenti.

Qualora non sia possibile utilizzare alcuna delle tecniche sopra menzionate, non essendo possibile accedere ai dati dei sistemi transazionali, sarà necessario registrare le modifiche in modo autonomo e trasferirle in seguito al warehouse.

La maggior parte dei DWH fornisce funzionalità OLAP nell'ambito dell'integrazione dei dati, che consentono di visualizzare i dati in strutture multidimensionali. L'On-Line Analytical Processing (OLAP) è un metodo di analisi che serve a sintetizzare i dati aziendali rilevanti per la gestione. La procedura si basa sul processo ETL:

- E = Extraction (estrazione): l'estrazione dei dati comporta la selezione di informazioni rilevanti provenienti da diverse fonti e può essere realizzata con la tecnica push o pull. Se l'estrazione dei dati segue la strategia push, le fonti vengono spinte a generare estratti a intervalli regolari e a trasferirli al DWH. Nel caso della strategia pull, è il DWH ad attivare l'estrazione dei dati.

- T = Transformation (trasformazione): i dati estratti vengono normalizzati e tradotti nel formato del database di destinazione.

- L = Loading (caricamento): la fase di caricamento prevede il salvataggio dei dati trasformati nei rispettivi database di destinazione del DWH.

Il livello di acquisizione dati di un DWH può contenere una staging area (detta anche area di lavoro). Si tratta di una sezione temporanea del database in cui i dati da caricare vengono pre-elaborati. Questa fase è necessaria soprattutto in caso di processi ETL complessi.

Dal momento che il DWH combina dati provenienti da un'ampia varietà di fonti, l'integrazione dei dati si basa su vari strumenti che consentono la trasformazione e la pulizia dei dati estratti. Questi dati possono essere assegnati alle seguenti categorie:

- Strumenti di migrazione dei dati: i programmi per la migrazione dei dati consentono di definire semplici regole di trasformazione per convertire dati sorgente eterogenei in un unico formato di destinazione.

- Strumenti di data scrubbing: lo scrubbing dei dati utilizza programmi basati sulla logica fuzzy e sulle reti neurali. L'obiettivo è migliorare la qualità dei dati correggendo errori, lacune e ripetizioni mediante regole, algoritmi e lookup table (LUT) predefiniti. In questo casi si parla anche di quality management (gestione della qualità).

- Strumenti di data auditing: gli strumenti di data auditing vengono impiegati nell'integrazione dei dati per determinare le regole e le relazioni tra i dati stessi. Programmi di questo tipo permettono anche di identificare i dati che violano le regole predefinite e quindi possono contenere errori.

L'integrazione è seguita dal trasferimento dei dati estratti al database centrale, il cosiddetto core data warehouse. Questo passaggio è supportato da programmi responsabili delle seguenti funzioni:

- Controllare l'integrità dei dati

- Riorganizzare i dati

- Calcolare le aggregazioni dei dati

- Calcolare le strutture di accesso

- Effettuare la partizione dei dati per un accesso efficiente

Archiviazione dei dati

Il livello di memorizzazione dei dati è il cuore del DWH e include il cosiddetto core data warehouse. I dati estratti vengono solitamente memorizzati nel DWH sotto forma di array multidimensionali (matrici), i cosiddetti schemi a stella e a fiocco di neve, e conservati in modo permanente per le analisi future. Tuttavia questi si riferiscono raramente all'intero stock del DWH: per una valutazione efficiente è quindi prassi comune creare estratti dell'intero set di dati, conosciuti come data mart.

Un data mart è una copia di un set di dati, implementato di regola come memoria temporanea. Tuttavia possono essere utilizzati anche i cosiddetti data mart indipendenti, che mantengono sempre disponibili delle specifiche sezioni di dati.

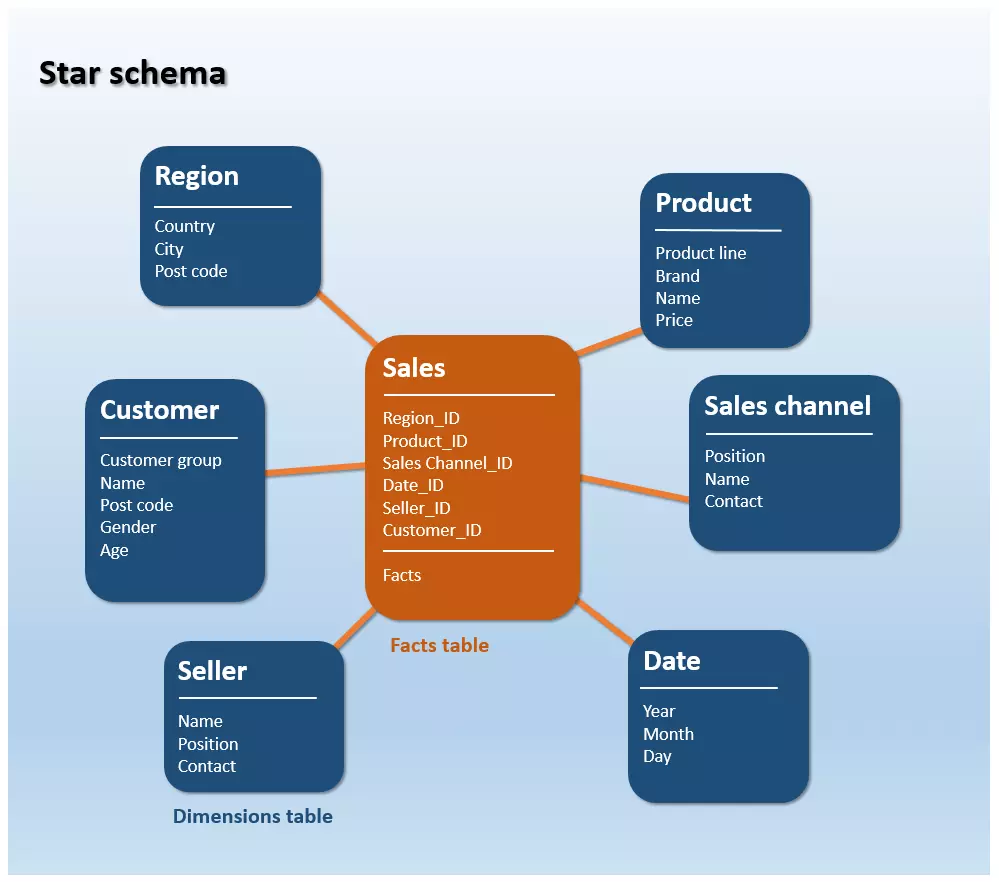

Uno schema a stella è un tipo di diagramma entità-associazione (Entity-relationship diagram, ERD), una rappresentazione grafica della struttura a tabelle di un database in cui sono illustrate le diverse entità e le relazioni che tra esse intercorrono. Lo schema a stella viene utilizzato per visualizzare strutture di dati multidimensionali.

Ogni schema a stella è costituito da una tabella dei fatti intorno alla quale sono raggruppate, a forma di stella, diverse tabelle delle dimensioni.

- La tabella dei fatti contiene i cosiddetti fatti: cifre chiave e risultati di un'azienda registrati su base continuativa (es. dati di vendita)

- Le tabelle delle dimensioni contengono gli attributi utilizzabili per descrivere i dati presenti nella tabella dei fatti, vale a dire una raccolta di informazioni relative agli eventi memorizzati.

In uno schema a stella (star schema), solo la tabella dei fatti è collegata a tutte le tabelle delle dimensioni attraverso relazioni con chiavi esterne. Non vengono invece stabiliti collegamenti tra le tabelle delle dimensioni. Il grafico seguente rappresenta in modo semplificato questa struttura di dati:

Nello schema sopra, il fatto "vendite" (sales) viene mostrato in relazione a uno specifico canale di vendita (sales channel), a un prodotto (product), a un venditore (seller), alla regione (region), al cliente (customer) o al periodo (date). Una domanda a tre dimensioni potrebbe essere ad esempio: quanto fatturato è stato realizzato con un determinato prodotto nel 2016 attraverso il canale di vendite online?

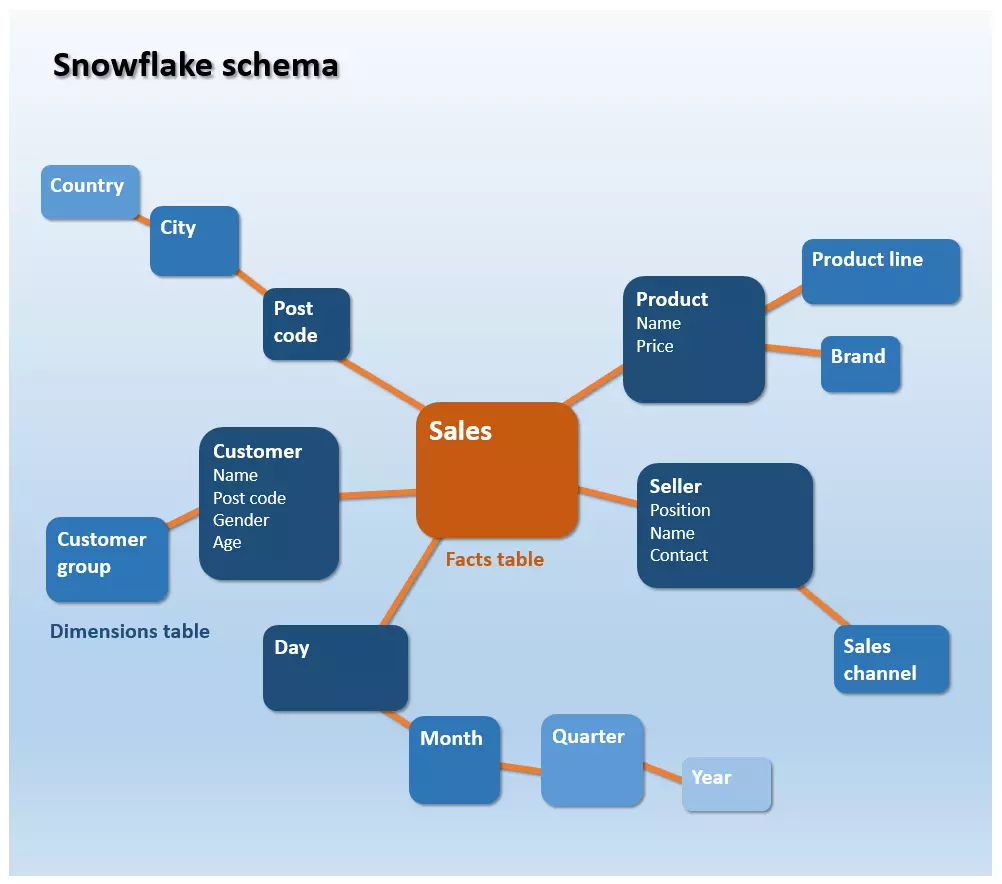

Un'estensione dello schema a stella è lo schema a fiocco di neve (snowflake schema). Mentre le tabelle delle dimensioni di uno schema a stella hanno forma denormalizzata, in uno schema a fiocco di neve le informazioni sono presentate secondo la terza forma normale (3NF). Si dà luogo quindi a una classificazione e gerarchizzazione dei dati, in cui le informazioni ridondanti vengono trasferite in nuove tabelle. Ne risulta la caratteristica ramificazione, che ricorda appunto un fiocco di neve.

Rispetto ai modelli a stella, i modelli a fiocco di neve sono caratterizzati da un minore consumo di spazio di archiviazione, conseguenza della memorizzazione normalizzata dei dati. La normalizzazione consiste nella rimozione dalle tabelle di colonne ridondanti, al fine di evitare la duplicazione delle voci. La riduzione delle ridondanze riduce anche lo sforzo necessario per la manutenzione dei dati: nella migliore delle ipotesi, ogni informazione è presente solo una volta e, se necessario, modificata solo una volta nell’intero sistema.

La conservazione dei dati in tabelle normalizzate conduce inevitabilmente a strutture di dati più complesse, che allungano solitamente tempi necessari per un’interrogazione. Se gli analisti vogliono accedere ai dati in uno schema a fiocco di neve, le tabelle dimensionali multilivello devono prima essere collegate in un join (gruppo).

Un join è un'operazione che permette di collegare attraverso chiavi esterne le tabelle di un database a determinate condizioni.

In pratica la struttura dei dati di un DWH si basa sullo schema a fiocco di neve, mentre i singoli data mart sono realizzati come schemi a stella.

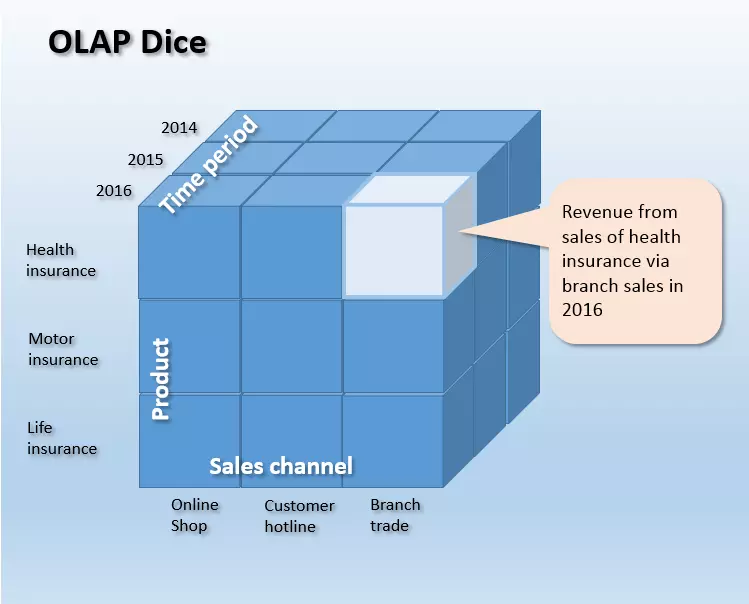

I diagrammi a stella e a fiocco di neve sono chiamati tabelle delle dimensioni, poiché ogni tabella può essere rappresentata come una dimensione di un cubo OLAP multidimensionale. Ciò consente agli analisti di confrontare i fatti memorizzati nel DWH in base a tutti i criteri di riferimento disponibili, al fine di analizzare le informazioni chiave dell’attività commerciale, come ad esempio le vendite, in maniera multidimensionale da diversi punti di vista e con diversi gradi di dettaglio.

La figura seguente rappresenta schematicamente un cubo OLAP tridimensionale i cui lati delineano le dimensioni Product (prodotto), sales channel (canale di vendita) e Time period (periodo di tempo). La lunghezza dei lati del cubo dipende dal numero di celle. Ogni cella cubica contiene esattamente un valore, ad esempio il fatturato dell'assicurazione sulla salute nel 2016 attraverso il canale delle vendite in filiale (evidenziato in bianco nel grafico).

Il metodo OLAP non è limitato alle tre dimensioni. Questo cubo di dati è n-dimensionale e può, in linea di principio, essere costituito da un numero illimitato di dimensioni.

A seconda della tecnologia su cui si basa il data warehouse centrale, si distingue fra tre metodi OLAP diversi. Se il cubo accede ai dati in un database relazionale, si chiama ROLA (OLAP relazionale). I cubi che invece si basano su database multidimensionali sono chiamati MOLAP (OLAP multidimensionali).

Livello di presentazione dei dati

Il livello di presentazione dei dati funziona da interfaccia per le applicazioni finali e gli strumenti di presentazione. I metodi per la valutazione e l'analisi dei dati vengono messi a disposizione dell'utente finale con vari strumenti. In questo modo è possibile estrarre le informazioni dal data pool del DWH e prepararle per gli utenti in formati di visualizzazione diversi. Lo spettro va dai tool di reporting e interrogazione agli strumenti di collaborazione, data mining, di elaborazione analitica online (OLAP) fino ai sistemi informativi esecutivi (EIS) e gli strumenti di previsione e simulazione.

Strumenti di reporting e interrogazione

Gli strumenti di reporting forniscono agli utenti finali varie funzioni per la creazione di report standard predefiniti (predefined reportings). Questo può essere fatto in automatico a intervalli regolari o su richiesta. Per rendere l'interrogazione del DWH più facile per gli utenti, è anche possibile predefinire gli strumenti di reporting attraverso sistemi di richiesta.

Strumenti di collaborazione

Gli strumenti di collaborazione supportano la comunicazione e la collaborazione degli utenti finali nel campo dell'analisi dei dati. Lo spettro funzionale di questi tool include, ad esempio, la memorizzazione delle note e lo scambio dei risultati delle analisi.

Strumenti di data mining

Con il termine data mining si intendono tutti i metodi di analisi non direzionali, parzialmente automatizzati, che mirano a identificare i modelli, i trend e le relazioni più importanti all'interno di un database.

Gli strumenti di data mining si basano su metodi statistici e matematici, nonché su tecniche di intelligenza artificiale (AI) di machine learning. Il volume di dati che le aziende generano, elaborano e raccolgono nei DWH a fini di analisi sta crescendo in modo esponenziale – a livello mondiale, raddoppia ogni due anni. Ne risulta l'importanza che il data mining ha assunto nel campo del data warehousing.

Strumenti di Online Analytical Processing (OLAP)

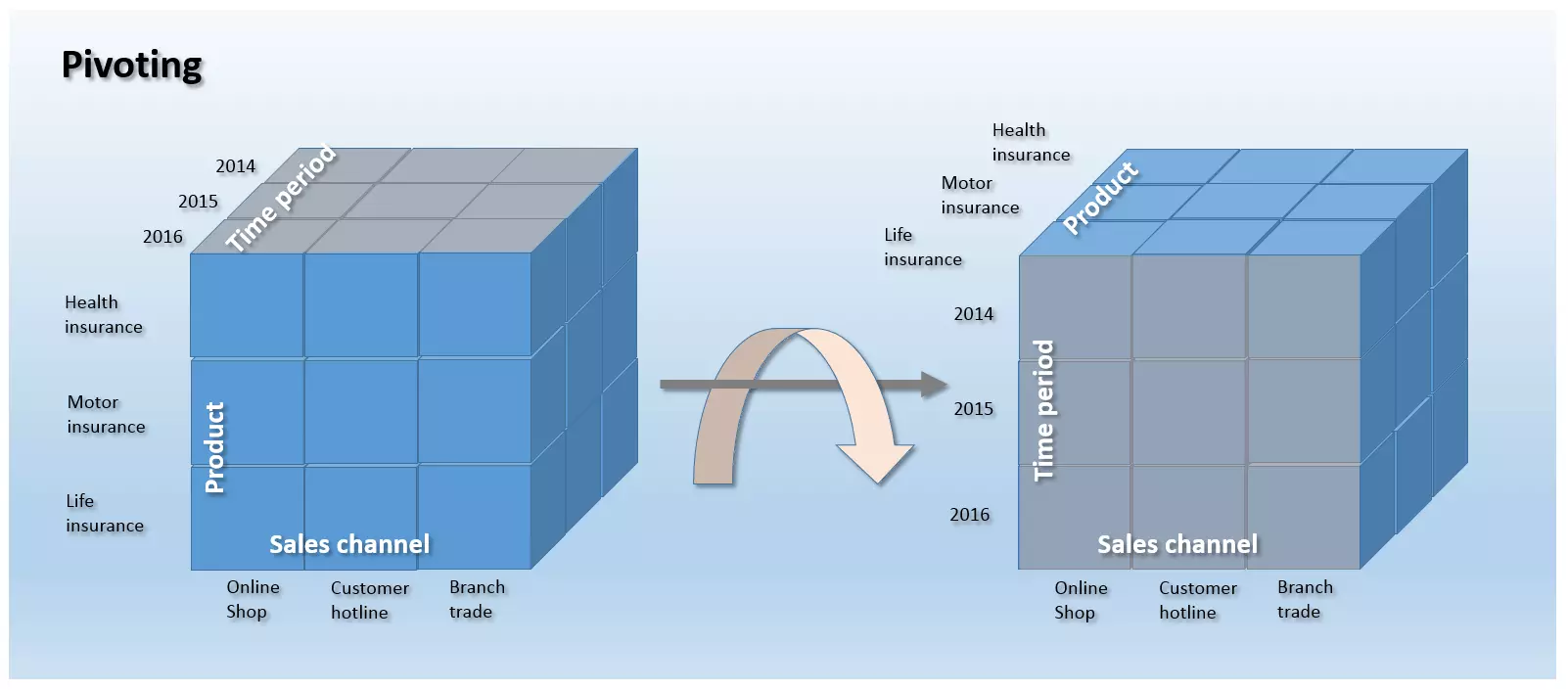

Tra gli strumenti disponibili per la valutazione e l'analisi dei dati nel campo del data warehousing, le applicazioni OLAP si sono affermate come interfacce utente standard. Queste mettono a disposizione degli utenti diverse funzioni utilizzabili per formulare richieste ad hoc al DWH e vengono utilizzate per navigare attraverso il set multidimensionale di dati. Gli strumenti di Online Analytical Processing sono in grado di presentare i dati secondo un qualsiasi numero di dimensioni predefinite: esistono infatti alcune operazioni di base per modificare un cubo OLAP.

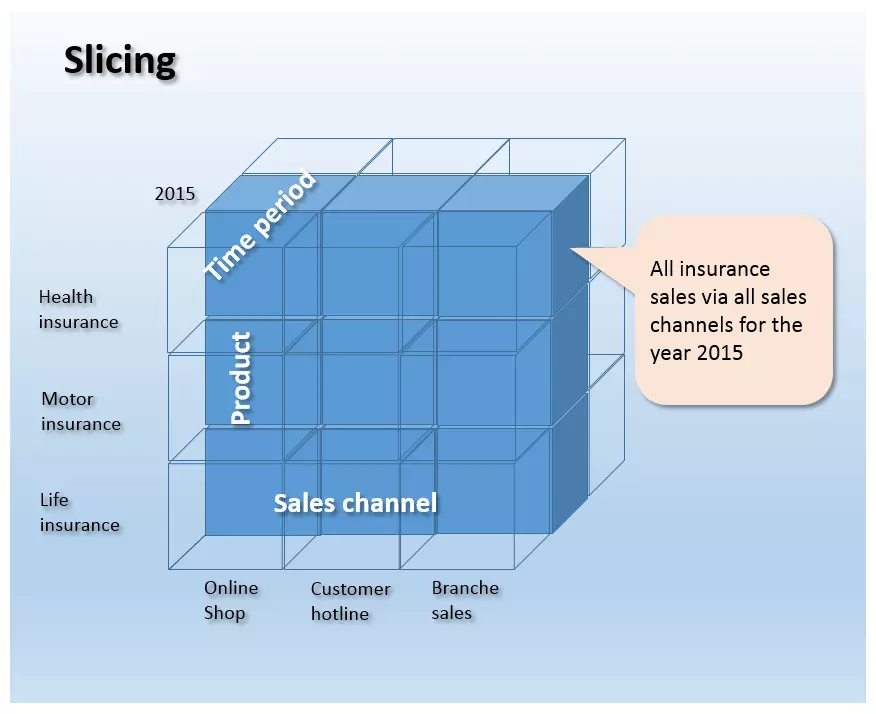

- Slicing: lo slicing è un processo in cui una dimensione di un cubo OLAP viene ridotta a sottoinsieme per essere visualizzata e analizzata separatamente.

Nella figura seguente, la dimensione Time Period viene limitata al 2015 e la sezione che ne risulta mostra le vendite in questo arco temporale di tutti i pacchetti assicurativi, attraverso tutti i canali di vendita.

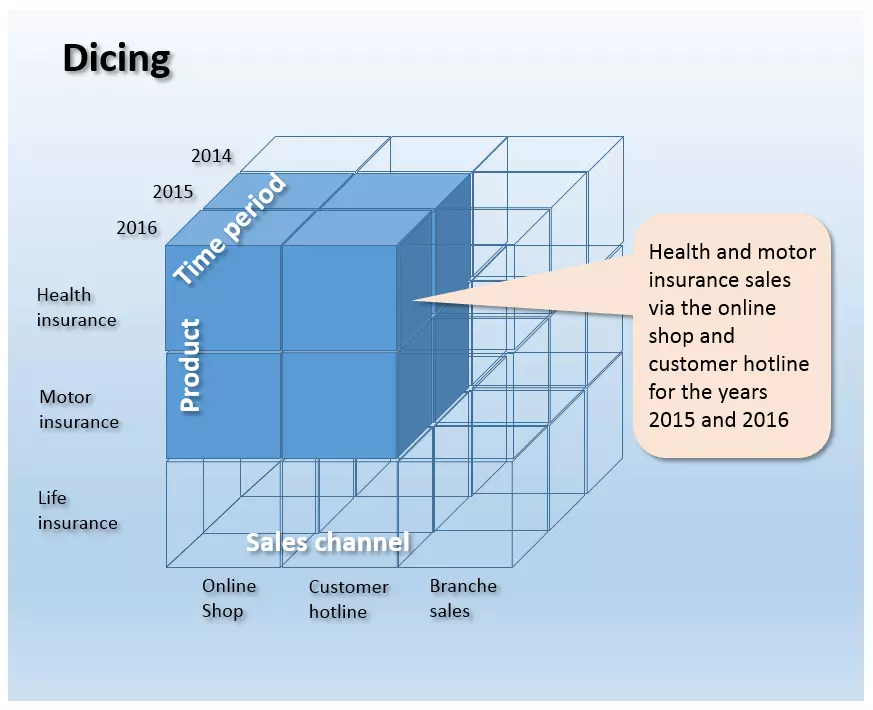

- Dicing: il dicing consiste nel taglio di un cubo OLAP attraverso più operazioni di slicing simultanee che interessano più dimensioni. In questo processo viene prodotto un cubo più piccolo rappresentante un sottoinsieme del cubo originale.

La figura seguente mostra un'operazione di dicing, attraverso la quale dal cubo integrale viene estratto un cubo più piccolo.

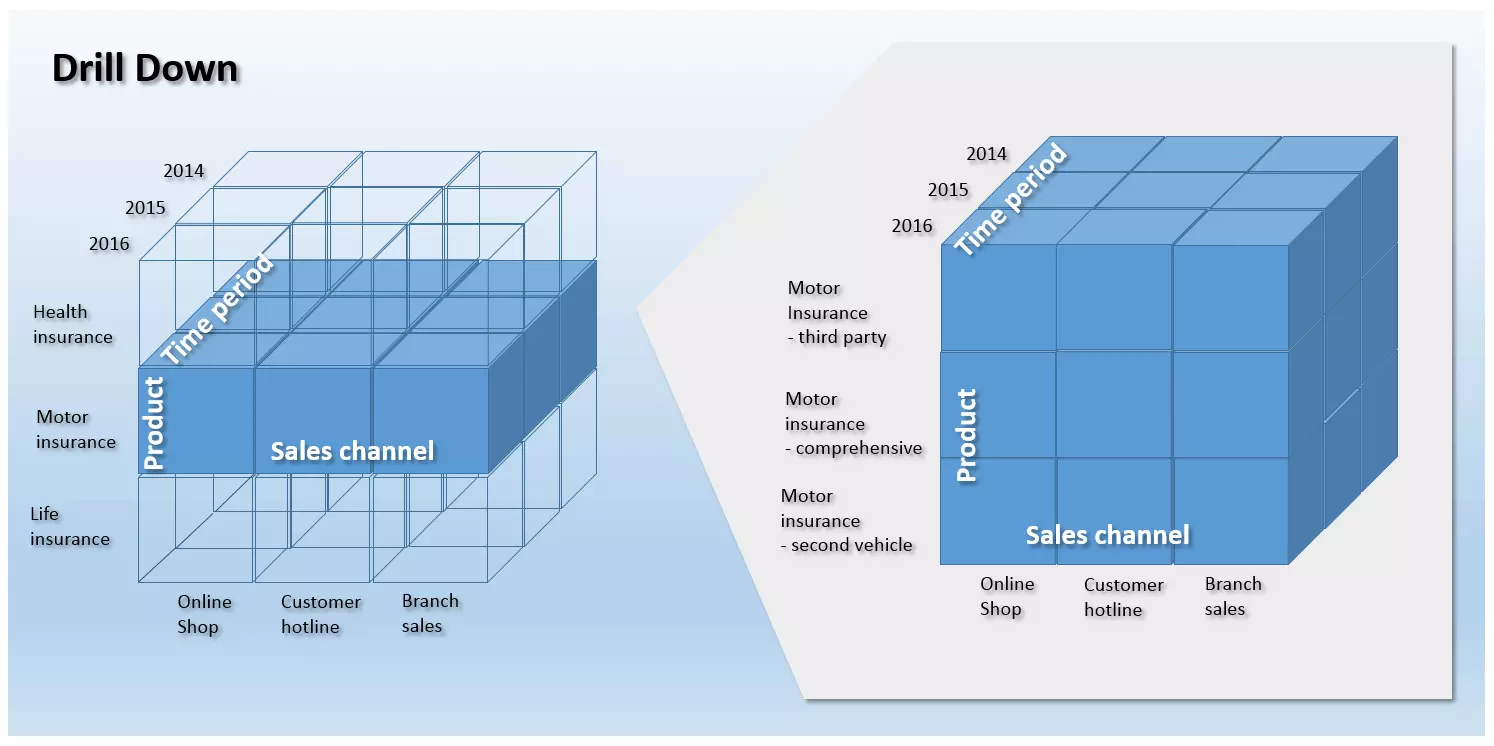

- Drill-down/Roll-Up: se si vogliono suddividere le aggregazioni di un oggetto informativo in valori più dettagliati, entra in gioco l'operazione del drill-down. Essa consente agli analisti di ingrandire un cubo OLAP, aumentando in questo modo la granularità dei dati. L'operazione inversa si chiama roll-up e consiste nel riassumere le informazioni in livelli gerarchicamente superiori. Drill-down e roll-up sono utilizzati per la navigazione in strutture gerarchiche multidimensionali.

Il grafico seguente mostra un drill-down della dimensione Products nell'ambito delle vendite. La granularità è aumentata in modo che i dati sulle vendite memorizzati nel DWH possano essere interpretati in relazione ai singoli prodotti.

- Drill-out/Split: Con questa operazione gli analisti sono in grado di aggiungere un'ulteriore dimensione al cubo OLAP, da cui risulteranno dati più specifici. A differenza del drill-down, il grado di dettaglio non aumenta in termini di granularità: piuttosto, le informazioni risultanti dalle dimensioni aggiunte contribuiscono ad aumentare la quantità dei dati disponibili.

- Drill-in/Merge: Operazione opposta al drill-out, il drill-in di un cubo OLAP ne riduce il livello di dettaglio rimuovendo una o più dimensioni. A differenza del roll-up, in questo caso la riduzione di informazioni non è una conseguenza della modifica dell'osservazione, ma della rimozione delle dimensioni. La granularità rimane inalterata.

- Drill-across: Anche l'operazione drill-across viene utilizzata nell'analisi del set di dati. Mentre tuttavia le operazioni viste sinora si riferiscono sempre ad un unico cubo OLAP, il drill-across viene applicato a più cubi di dati correlati al fine di ottenere un'analisi globale. Un numero qualsiasi di tabelle fattuali vengono analizzate allo stesso livello gerarchico e granulometrico (cioè mantenendo inalterato il livello di osservazione).

- Drill-through: Il drill-through consiste nella selezione di una singola cella di un cubo di dati e nella sua analisi con il massimo livello di dettaglio. A differenza del drill-down, questa operazione consente di accedere ai dati sorgente della cella cubica selezionata. Il risultato deriva quindi dalle celle della tabella sulle quali si basa il calcolo delle celle selezionate.

Executive Information Systems (EIS)

Gli strumenti EIS, similmente a quelli OLAP, offrono agli utenti diverse opzioni per la formulazione di query ad hoc e la modellazione dei dati. La differenza consiste nel fatto che il termine EIS è legato principalmente a sistemi applicativi pronti all'uso, che forniscono rapporti predefiniti per specifiche aree di attività come le vendite, il marketing e la pianificazione finanziaria.

Strumenti di forecasting e simulazione

Gli strumenti di forecasting e simulazione consentono agli utenti finali di impiegare i dati memorizzati nel DWH per creare dei modelli di previsione.

Gestione di un data warehouse

Su tutti i livelli di un DWH sono attivi strumenti speciali, tutti appartenenti all'ambito della gestione del magazzino (warehouse management). Queste componenti si occupano dell'architettura, della manutenzione e della gestione delle funzioni amministrative necessarie per l’immagazzinamento dei dati. I compiti principali di un DWH manager sono la pianificazione dei processi del magazzino di dati e il controllo del funzionamento dei metadati, della sicurezza e del sistema.

- Scheduling: lo scheduling (pianificazione) è il controllo dei processi di un DWH. Le funzioni amministrative nell'ambito della pianificazione possono essere categorizzate nel modo seguente in relazione ai livelli dell'architettura del data warehouse:

- Acquisizione e integrazione dei dati: a livello di acquisizione dati, il DWH manager è responsabile della progettazione e dell'adattamento dei processi ETL. Inoltre sono disponibili funzioni di amministrazione per monitorare gli aggiornamenti e per il controllo qualità.

- Memorizzazione dei dati: a livello di memorizzazione dei dati, il DWH manager controlla che la memoria sia sfruttata al massimo, crea le tabelle di aggregazione e gestisce le operazioni di archiviazione e backup.

- Presentazione dei dati: a questo livello, le funzioni del DWH manager includono la gestione degli utenti e il monitoraggio dei tempi di esecuzione delle richieste.

- Acquisizione e integrazione dei dati: a livello di acquisizione dati, il DWH manager è responsabile della progettazione e dell'adattamento dei processi ETL. Inoltre sono disponibili funzioni di amministrazione per monitorare gli aggiornamenti e per il controllo qualità.

- Gestione dei metadati: Il repository dei metadati è una componente fondamentale del DWH manager. Esso contiene tutte le informazioni necessarie per la costruzione e il funzionamento del DWH. I metadati memorizzati nel repository includono, ad esempio, la definizione dello schema del database, le informazioni sulle strutture di memoria, i percorsi di accesso e le dimensioni dei file, i metadati che descrivono le fonti dei dati e i tempi di aggiornamento, le regole di pulizia e trasformazione dei dati, gli indici e le tabelle di partizione. Inoltre, il DWH Manager assicura lo scambio di metadati tra i singoli componenti del DWH e fornisce quindi una base di metadati omogenea.

- Gestione della sicurezza: la gestione della sicurezza comprende diversi servizi di autenticazione degli utenti, autorizzazione e crittografia.

- Gestione del sistema: Nell'ambito della gestione del sistema, il DWH manager offre diverse funzioni amministrative che servono al funzionamento del data warehouse. Queste includono, ad esempio, il monitoraggio (performance, sfruttamento massimo, etc.), l'archiviazione dei dati e il backup.

Data Warehousing e protezione dei dati

L'aggregazione su larga scala di dati operativi, aziendali o relativi ai clienti, nonché l'analisi di enormi quantità di dati con il supporto dei metodi di data mining o delle applicazioni OLAP, sono per le imprese un'ottima occasione di ottimizzare i processi interni in maniera duratura. Ma oltre agli indiscutibili vantaggi che l'analisi dei big data comporta in termini di processi decisionali, non mancano le preoccupazioni sollevate dagli esperti in materia di protezione dei dati e dovute ai rischi connessi a tale analisi, in particolare per quanto concerne il diritto fondamentale all'autodeterminazione informativa e la tutela della privacy.

Le critiche riguardano soprattutto questioni delicate come la possibilità, offerta dall'analisi dei dati, di creare profili della personalità degli utenti e prevederne i comportamenti futuri. Il dibattito si concentra anche sul potenziale di manipolazione delle informazioni ottenute dall’analisi dei dati.

A partire da maggio 2018 è entrato in vigore il nuovo Regolamento Europeo relativo al trattamento dei dati personali, che regolano in modo restrittivo l’archiviazione e il trattamento dei dati, ponendo l’accento sul consenso informato dell’utente e sulla possibilità da parte dell’utente di eliminare questi dati. Con questo nuovo regolamento si prende atto del fatto che i dati personali sono un nuovo e remunerativo oggetto di mercato, e ci si preoccupa di tutelare l’individuo dai possibili attacchi alla libertà personale connessi a questo nuovo mercato.

Questi i punti fondamentali:

- Principio di accountability: chi raccoglie i dati è ora ritenuto “accountable”, cioè responsabile delle misure opportune per tutelare i diritti dell’utente e per evitare violazioni. Queste misure possono comprendere ad esempio la cifratura dei dati;

- L’utente deve sempre poter dare il proprio consenso esplicito e ha diritto a sapere chi utilizzerà i suoi dati, per quanto tempo e per quali scopi;

- L’utente deve poter revocare il proprio consenso in qualsiasi momento

L’introduzione di un responsabile protezione dati e le multe previste per inadempienze testimoniano la serietà con cui l’argomento è preso in considerazione.

Software di data warehouse

Di data warehouesing non si discute più soltanto ai piani alti delle grandi aziende: anche le piccole e medie imprese (PMI) hanno l'opportunità di ottimizzare i processi attraverso l'analisi dei big data. Oltre alle costose suite BI e alle soluzioni DHW integrate, sono da qualche anno disponibili sul mercato prodotti entry level a basso costo, servizi cloud flessibili e applicazioni open source complete che si adattano soprattutto alle esigenze delle imprese di medie dimensioni.

Prodotti a pagamento per il data warehousing

Un software BI è generalmente caratterizzato da elevata affidabilità, da una gamma di servizi concordati sulla base di un service level agreement (SLA) e da un'assistenza professionale. Gli acquirenti devono considerare la variabilità dei costi in base al fatto che il prodotto venga acquistato o utilizzato direttamente su cloud.

L'elenco seguente è una panoramica sui prodotti a pagamento per il data warehousing: si tratta dei software dei principali provider, presentati in ordine alfabetico.

| Fornitori del software proprietario | Prodotti di data warehosing |

|---|---|

| Amazon Web Services | Amazon Redshift |

| Cloudera | Cloudera Enterprise |

| Hewlett Packard Enterprise | HP Vertica, HP ArcSight Data-Platform, HP Haven OnDemand, HP IDOL, HP Key View |

| IBM | IBM Netezza, IBM PureData System, IBM InfoSphere DataStage |

| Microsoft | SQL Server, Microsoft Analytics Platform System, Azure HDInsight for Hadoop |

| Oracle | Oracle Business Intelligence, Oracle Database, Oracle Exadata Database Machine, Oracle NoSQL Database,Oracle TimesTen In-Memory Database, Oracle Big Data Appliance |

| Pivotal Software | Pivotal Greenplum, Pivotal Big Data Suite, Pivotal HDB (powered by Apache HAWQ), Pivotal HDP (OEM Hortonsworks Data Platform) |

| SAP | SAP NetWeaver Business Intelligence, SAP IQ, SAP HANA Enterprise Cloud |

| SAS | SAS Data Management, SAS Access Interface to Hadoop, SAS Federation Server, SAS Data Loader for Hadoop, SAS Event Stream Processing |

| Snowflake Computing | Snowflake |

| Teradata | Teradata Active Enterprise Data Warehouse, Teradata Data Warehouse Appliance, Teradata Appliance for Hadoop, Teradata Integrated Big Data Platform, Teradata Aster Big Analytics Appliance |

Soluzioni open source

Oltre ai prodotti a pagamento, sono disponibili sul mercato alcuni software di business intelligence open source che offrono soluzioni gratuite per il data warehousing. Nella panoramica che segue, tratta da una pubblicazione tedesca dal titolo “Strumenti di Business Intelligence: panoramica di mercato di strumenti open source nel settore della Business Intelligence”, sono riportati i programmi di BI open source più comuni e le rispettive aree di applicazione.

| BI Software | Estrazione dati grezzi | Trasformazione dati grezzi | Caricamento dati trasformati | OLAP | Data Mining | Dash-boards | Report |

|---|---|---|---|---|---|---|---|

| Pentaho DI | - | - | - | - | |||

| Talend OS | - | - | - | - | |||

| Jasper ETL | - | - | - | - | |||

| Pentaho Mondrian | - | - | - | - | |||

| Jedox | - | - | - | ||||

| BIRT | - | - | - | - | |||

| SQL Power Wabit | - | - | - | ||||

| KNIME | - | ||||||

| RapidMiner | |||||||

| Weka | - | - | |||||

| JasperSoft | |||||||

| Pentaho | |||||||

| SpagoBI |

I software open source elencati possono essere assegnati alle aree di applicazione ETL, OLAP, data mining e reporting. Inoltre sono disponibili soluzioni di BI integrate che coprono tutti gli ambiti indicati.

Software ETL

Per la raccolta e l'integrazione dei dati nell'ambito dei processi ETL si può usufruire dei servizi open source di Pentaho DI, Talend OS e Jasper ETL.

- Pentaho D: anche noto come Kettle, lo strumento ETL Pentaho Data Integration (DI) è parte della suite Pentaho BI, ma può essere utilizzato come applicazione indipendente nelle architetture di data warehouse. Il tool di acquisizione e integrazione dati è dotato di un'interfaccia grafica che non richiede agli utenti competenze pregresse nel campo della programmazione. Pentaho DI offre un'ampia scelta di moduli con i quali è possibile definire le singole fasi del processo ETL e supporta tutti i comuni sistemi di banche dati. Fonti di dati possono anche essere flat file come CSV, Excel o file di testo. Inoltre questo strumento fornisce interfacce per suite di BI proprietarie di SAS e SAP, oltre che per software di analisi come Google Analytics.

- Talend OS: paragonabile a Pentaho DI è lo strumento open source ETL di Talend. Talend Open Studio (OS) consente in aggiunta di definire i processi di acquisizione e integrazione dei dati mediante moduli parametrizzati (i cosiddetti jobs). Il programma mette a disposizione interfacce per tutte le fonti di dati più comuni e varie funzioni di trasformazione dei dati. Un editor di mappe consente agli utenti di trasferire dati grezzi eterogenei in una struttura di destinazione predefinita. Come nel caso di Pentaho DI, gli utenti di Talend senza competenze di programmazione possono beneficiare di un'interfaccia utente grafica.

- Jasper ETL: Jasper ETL è il risultato di una collaborazione tra Jaspersoft e Talend. Lo strumento ETL si basa essenzialmente su Talend OS, il leader tra i programmi open source per l'integrazione dei dati. È particolarmente adatto se si utilizzano altri prodotti BI Jaspersoft nell'ambito dell'architettura DWH.

Applicazioni OLAP

Pentaho Mondrian und Jedox sono strumenti OLAP consolidati a licenza open source.

- Pentaho Mondrian: Mondrian è un server OLAP basato su java. Inizialmente sviluppato come progetto open source a se stante, Mondrian dal 2006 è parte della Pentaho BI Suite, pur rimanendo comunque a disposizione degli utenti come applicazione standalone. Inoltre Mondrian viene utilizzato nelle soluzioni BI di altri fornitori open source come Jaspersoft. Gli utenti beneficiano del raggruppamento delle risorse open source, che consente progetti collaborativi come il Mondrian Schema Workbench o l’interfaccia OLAP4J. Il progetto Mondrian segue un approccio relazionale (ROLAP): sulla base dei dati forma un database relazionale le cui tabelle sono organizzate in schemi a stella o a fiocco di neve.

- Jedox: il produttore di software offre con la suite BI omonima una soluzione completa per le applicazioni di business intelligence e performance management. Punto focale del software è un potente server OLAP in-memory che si può integrare anche in altri ambienti software attraverso le interfacce per Java, PHP, C/C++ o .NET. Si presta soprattutto per utenti in ambito KMU a causa dell’add-in di Excel, attraverso il quale il server OLAP può essere utilizzato anche con il celebre software di fogli di calcolo.

Data Mining

Anche per quanto riguarda il data mining sono disponibili prodotti a licenza open source. Tra questi consigliamo KNIME, RapidMiner e Weka.

- KNIME: KNIME sta per “Konstanz Information Miner”, uno strumento per il data mining sviluppato dall’Università di Costanza. Si tratta di un software libero che offre agli utenti metodi di analisi di vasta portata e diverse opzioni di integrazione per diversi algoritmi di data mining e machine learning grazie ad un concetto di pipeline modulare. Le singole fasi di preelaborazione dei dati (ETL), modellazione, analisi e virtualizzazione si possono definire tramite un’interfaccia utente grafica trascinando i blocchi con Drag&Drop nello spazio di lavoro e unendoli tra loro. KNIME.com, con sede a Zurigo, offre la possibilità di dowload gratuito del software. Se lo desiderano, gli utenti possono usufruire anche di un’assistenza tecnica professionale e di servizi di consulenza. Il programma scritto in Java è offerto come plug-in per lo strumento di programmazione Eclipse (IDE).

- RapidMiner: la piattaforma di analisi RapidMiner dell’azienda omonima offre agli utenti un ambiente integrato per l’apprendimento automatico, per il mining di dati, testi e web, e per analisi umorali e temporali, nonché modelli di previsione in un modello open core. L’assistenza abbraccia tutte le fasi del processo di data mining, incluse la preparazione, la visualizzazione, la validazione e l’ottimizzazione dei dati. Se qualche utente dovesse ritenere insufficiente la versione Community gratuita con soltanto un processore logico e un’ampiezza di analisi di massimo 10.000 record, può optare per un upgrade alla licenza a pagamento Enterprise. Il programma è scritto in Java e offre un’interfaccia utente grafica con la quale si può definire ed eseguire comodamente il workflow dell’analisi con un clic del mouse.

- Weka: Weka (Waikato Environment for Knowledge Analysis) è un progetto open source dell’università di Waikato, Nuova Zelanda. Lo strumento di analisi offre agli utenti diversi algoritmi nell’ambito del machine learning. Accanto ai classici metodi di data mining come classificazione, associazione e analisi della regressione o dei cluster, Weka contiene diversi moduli per la preparazione e virtualizzazione dei dati. Il programma scritto in Java offre un’interfaccia utente grafica e tutte le funzioni del software si possono eseguire tramite riga di comando. Se necessario, Weka si può inoltre integrare attraverso un’interfaccia Java nelle proprie soluzioni software.

Modalità per i report

Nell’ambito delle modalità dei report si consigliano strumenti open source come BIRT e SQL Power Wabit, che offrono accanto alle classiche funzioni di report mensile, trimestrale e annuale anche funzioni ad hoc che forniscono informazioni rilevanti in tempo reale.

- BIRT: BIRT (Business Intelligence and Reporting Tools) è un progetto open source senza scopo di lucro di Eclipse Foundation che mette a disposizione funzioni di BI reporting per rich client e applicazioni web. Il software è adatto ad applicazioni basate su java e copre ampi settori della visualizzazione dei dati e del reporting. I design per i report BIRT vengono creati in un’interfaccia utente grafica basata sullo strumento open source di programmazione Eclipse e salvati come file XML.

- SQL Power Wabit: con lo strumento di reporting SQL Power Wabit gli utenti creano report sulla base delle classiche interrogazioni ai database. I cubi OLAP vengono supportati soltanto se è presente una descrizione della struttura dei dati. Il tool supporta report standard, domande ad hoc, pagine di riepilogo personalizzate e operazioni di drill-down nell’ambito dell’On-line Analytical Processing. Con funzionalità come il comando drag&drop, l’attualizzazione dei report in tempo reale, una funzione di ricerca globale e un editor WYSIWYG per la progettazione dei report, SQL Power Wabit è adatto anche per utenti senza conoscenze SQL. I report vengono creati comodamente con un clic e si possono personalizzare per quanto riguarda il carattere, il colore e il layout.

Soluzioni BI integrate

Accanto alle suite BI a pagamento di fornitori affermati come SAP, Oracle, IBM, SAS, HP o Microsoft, nel mercato open source si trovano anche progetti software che forniscono soluzioni di data warehousing come raccolte di programmi integrate. Si consigliano Pentaho CE, Jaspersoft e SpagoBI.

- Pentaho Communit Edition (CE): La Suite Pentaho BI comprende oltre agli sviluppi propri anche una serie di progetti open source esistenti che sono stati gradualmente acquistati e integrati nel portafoglio prodotti. I punti di forza del progetto risiedono nell’integrazione dei dati e nell’automatizzazione dei report. La raccolta dei programmi comprende:

- Pentaho Business Analytics Platform: La BA Platform è un’applicazione web che permette agli utenti di congiungere tutte le informazioni in una piattaforma centrale.

- Pentaho Data Integration. Pentaho DI è il tool ETL descritto sopra.

- Pentaho Report Designer (PRD): PRD è un ampliamento del progetto JFreeReport. La soluzione di reporting open source supporta diversi formati di output come ad esempio PDF, Excel, HTML, Text, Rich Text File, XML e CSV.

- Pentaho Marketplace: Il marketplace permette agli utenti di aggiungere plug-in alla piattaforma Pentaho con un clic.

- Pentaho Aggregation Designer (PAD): Con PAD gli utenti possono creare e ottimizzare i contenuti di un database. Il cuore del tool è rappresentato dal server OLAP Mondrian.

- Pentaho Schema Workbench (PSW): PSW è un’interfaccia grafica di design che consente agli utenti di creare e testare schemi per cubi OLAP Mondrian.

- Pentaho Metadata Editor (PME): PME offre una descrizione dettagliata delle strutture dei dati che stanno alla base con l’aiuto di un file XML.

Con Pentaho Enterprise Edition (EE) si offre una versione a pagamento della Suite BI con uno spettro di funzioni ampliato nonché un’assistenza professionale.

- Jaspersoft: anche Jaspersoft offre diverse applicazioni DWH in una soluzione BI integrata. L’insieme dei programmi comprende:

- JasperReports Server: il JasperReports Server è un server per report che mette a disposizione le funzionalità OLAP attraverso un server Mondrian adattato.

- JasperReports Library: i report vengono creati grazie a una biblioteca Java.

- Jaspersoft Studio: Jaspersoft Studio è un editor per la preparazione dei report, incluso nella Suite BI

- Jaspersoft ETL: questo strumento ETL basato su Talend OS è stato ampiamente descritto sopra.

- Mobile BI: Mobile BI è un’app nativa per iPhone e Android che permette l’accesso da dispositivi mobili a report e dashboard.

Anche Jaspersoft si trova con uno spettro di funzioni ampliate in una versione commerciale e a pagamento.

- SpagoBI: a differenza di Pentaho e Jaspersoft, che offrono i propri prodotti con due modalità, una gratuita ed una a pagamento, SpagoWorld mette a disposizione esclusivamente soluzioni open source, anche per la Suite BI. Gli utenti commerciali possono sempre considerare una configurazione professionale nonché la personalizzazione del software come servizio a pagamento. L’insieme dei programmi include le seguenti componenti:

- SpagoBI Server: il server SpagoBI è il vero e proprio cuore della Suite BI open source, che fornisce tutti gli strumenti e le funzionalità di analisi.

- SpagoBI Studio: SpagoBI Studio è un ambiente di sviluppo integrato.

- SpagoBI Meta: SpagoBI Meta offre agli utenti un ambiente per la gestione dei metadati.

- SpagoBI SDK: con SpagoBI SDK la suite SpagoBI dispone di un livello di integrazione che consente di collegare diversi tool esterni: per esempio Talend OS (ETL), Jedox o Mondrian (OLAP), Weka o R (Datamining) così come BIRT o JasperReports Library (modalità di report).

Data management

Anche nell’ambito del data management, gli utenti hanno diverse alternative ai sistemi proprietari, come ad esempio Microsoft SQL Server, IBM DB2 o soluzioni di Oracle e Teradata, che sono disponibili come progetti di software open source. Come memoria dati centrale i sistemi di database relazionali MySQL e MariaDB o il DBMS object-relational PostgreSQL. Quest’ultimo è offerto da Pivotal sotto il nome di Greenplum Database come miglioramento ottimizzato specificamente per le architetture di data warehouse open source.

Conclusione: Data warehousing nelle medie imprese

Il data warehousing è arrivato nella media impresa. Il mercato delle soluzioni di BI e dei sistemi di data warehouse offre costose soluzioni aziendali ma anche una vasta gamma di utili progetti open source. Per piccole e medie aziende cala quindi l’ostacolo finanziario irrimediabilmente associato all’analisi dei big data.

Le piccole e medie imprese (PMI) nell’introdurre soluzioni di BI dovrebbero innanzitutto prendere in considerazione le modalità di report. Gli imprenditori possono ottenere un primo valore aggiunto facendo incontrare i dati esistenti con spese facili da gestire. Se nel corso della valutazione emergono lacune nel set di dati, il passo successivo dovrebbe essere concentrarsi sulla riorganizzazione della raccolta di dati utilizzando gli strumenti ETL o OLAP qui presentati. Il completamento dell’integrazione di un’architettura di data warehouse nella relativa infrastruttura IT è costituito dagli strumenti di data mining, che attraverso analisi avanzate (per esempio analisi del carrello) identificano nuovi trend e connessioni e forniscono in tal modo un input importante per decisioni strategiche.

Le medie imprese che desiderano creare un data warehouse dovrebbero porre attenzione fin dall’inizio all’implementazione della strategia di BI in conformità ai nuovi regolamenti sulla protezione dei dati.