Apache Spark: definizione e funzioni

Rispetto ad altri programmi, ad esempio il predecessore Hadoop o PySpark, software della concorrenza, Apache Spark spicca per la sua performance impressionante. Questo aspetto è essenziale per poter interrogare, elaborare e analizzare grandi quantità di dati. In qualità di framework di Big Data e di analisi con approccio in-memory, Spark offre numerosi vantaggi per l’analisi dei dati, l’apprendimento automatico, lo streaming dei dati e il linguaggio SQL.

Cos’è Apache Spark?

Apache Spark, framework di analisi dati creato a Berkeley, è attualmente considerato una delle piattaforme di Big Data più diffuse al mondo ed è un “Top-Level Project” della Apache Software Foundation. Questo motore si utilizza per elaborare simultaneamente grandi quantità di dati e applicazioni di analisi di dati in diversi cluster di computer. Spark è stato sviluppato per soddisfare i requisiti dei Big Data in termini di velocità di calcolo, estensibilità e scalabilità.

A tal proposito presenta moduli integrati che offrono numerosi vantaggi per il cloud computing, l’apprendimento automatico, le applicazioni basate sull’intelligenza artificiale e le basi di dati a grafo. Grazie alla sua potenza e alla scalabilità, il motore viene usato anche da grandi aziende quali Netflix, Yahoo ed eBay.

Cosa rende così particolare Apache Spark?

Apache Spark è un motore di analisi decisamente più rapido e potente rispetto ad Apache Hadoop o Apache Hive. Rispetto a MapReduce di Hadoop elabora i dati 100 volte più velocemente se il processo avviene in memoria e 10 volte più velocemente se invece avviene su disco rigido. Offre quindi alle aziende prestazioni che riducono i costi e aumentano l’efficienza.

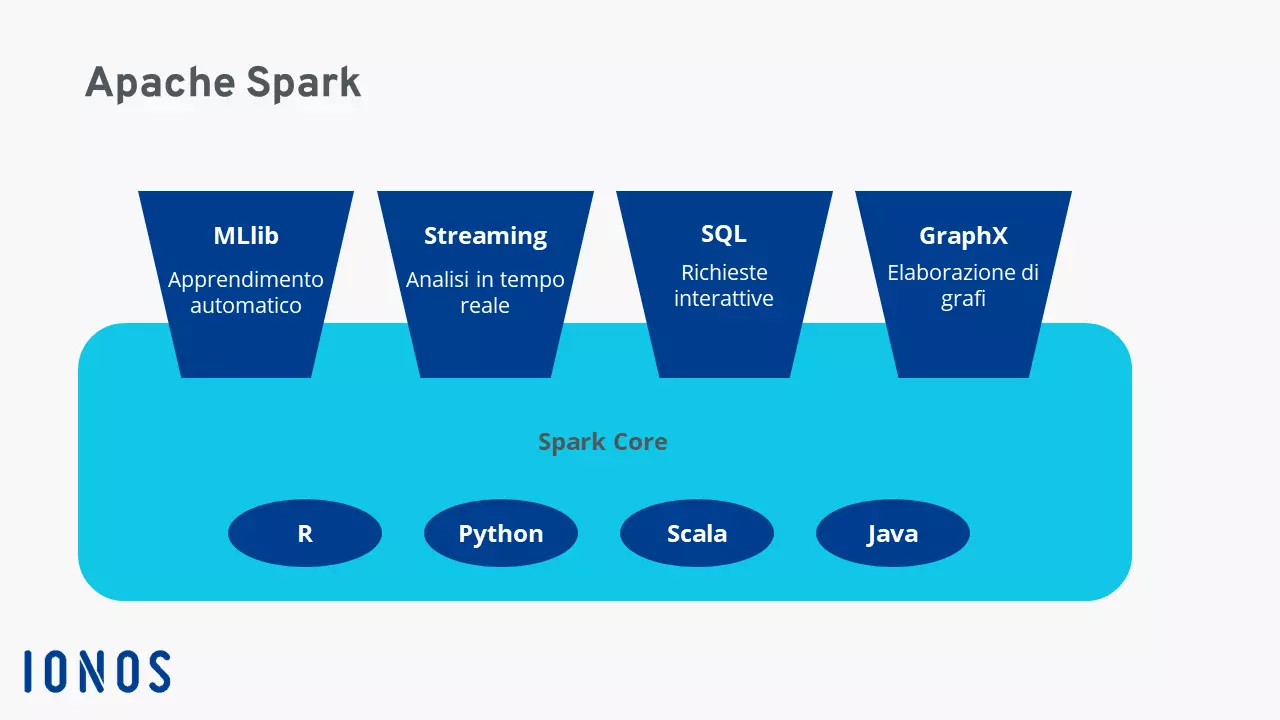

Spark, tuttavia, spicca in particolare per la sua flessibilità. Il motore non funziona solo in modo indipendente, ma anche organizzato in cluster Hadoop controllati da YARN. Inoltre, se sei uno sviluppatore, puoi scrivere applicazioni per Spark in vari linguaggi di programmazione. A tal proposito puoi usare SQL, o anche Python, Scala, R e Java.

Altre particolarità di Spark: il software non deve essere configurato sul file system di Hadoop, ma può essere utilizzato anche con altre piattaforme di dati come AWS S3, Apache Cassandra o Hbase. Inoltre, se si specifica l’origine dei dati, elabora sia processi batch come in Hadoop, sia dati in streaming e diversi carichi di lavoro con un codice quasi identico. Con un processo di interrogazione interattivo consente di distribuire i dati attuali e storici in tempo reale, comprese le analisi su livelli diversi, su disco rigido e memoria ed elaborati in parallelo.

Come funziona Spark?

Il funzionamento di Spark si basa su un principio gerarchico primary-secondary (in passato noto anche come principio master-slave). A questo scopo, il driver di Spark funge da nodo master gestito dal cluster manager. Questo a sua volta controlla i nodi slave e inoltra le analisi dei dati al client. Le esecuzioni e le interrogazioni sono distribuite e monitorate tramite lo SparkContext creato dal driver Spark, il quale collabora con i cluster manager, ad esempio quelli offerti da Spark, YARN, Hadoop o Kubernetes. In questo modo si creano anche Resilient Distributed Datasets (RDD).

È quindi Spark a determinare quali risorse verranno utilizzate per interrogare o archiviare i dati o anche dove inviare i dati ricavati dall’interrogazione. Elaborando i dati direttamente nella memoria ad accesso casuale dei cluster di server, il motore aiuta a ridurre la latenza e offre così una performance molto elevata in termini di rapidità. A questo si aggiungono fasi di elaborazione parallela e l’uso di una memoria virtuale e fisica.

Inoltre, Apache Spark elabora anche dati da diverse memorie. Annoveriamo ad esempio Hadoop Distributed File System (HDFS) e gli archivi di dati relazionali come Hive o database NoSQL. Infine, a seconda delle dimensioni dei record di dati, l’elaborazione in-memory o su disco rigido aiuta a migliorare le prestazioni.

Gli RDD: insiemi di dati distribuiti e tolleranti all’errore

I Resilient Distributed Datasets costituiscono una base importante in Apache Spark perché consentono di elaborare dati strutturati e non strutturati. Questi sono definiti aggregazioni di dati tolleranti agli errori che, mediante il clustering, vengono distribuite ed elaborate su cluster di server o spostate sulla memoria di un disco. È possibile anche il passaggio ad altri modelli di analisi. I record di dati negli RDD sono suddivisi in partizioni logiche che possono essere interrogate, create, elaborate o calcolate attraverso trasformazioni e azioni.

Con l’Hosting Linux di IONOS puoi usare i database secondo le tue esigenze. Una soluzione scalabile, con certificato SSL e protezione DDoS nonché server sicuri in Europa.

DataFrame e set di dati

I DataFrame e i set di dati sono altri tipi di dati elaborati da Spark. I DataFrame sono API strutturate in tabelle di dati con righe e colonne. I set di dati invece sono un’estensione DataFrame da usare con un’interfaccia utente orientata agli oggetti per la programmazione. Con la loro struttura uniforme, i DataFrame svolgono un ruolo centrale in tutti i linguaggi di programmazione sotto forma di API soprattutto in relazione alla Machine Learning Library (MLlib).

Quale linguaggio usa Spark?

Spark è stato sviluppato in Scala, il linguaggio primario del motore Spark Core. Inoltre, offre connettori Java e Python. Python offre numerosi vantaggi per quanto riguarda l’analisi dei dati soprattutto per la Data Science e il Data Engineering eseguiti con Spark in combinazione con altri linguaggi di programmazione. Spark supporta anche interfacce API per il linguaggio di programmazione R applicabile a grandi record di dati e utilizzabile per l’apprendimento automatico.

Quando viene usato Spark?

Grazie alle diverse librerie e memorie Spark, le API compatibili con numerosi linguaggi di programmazione e l’efficace elaborazione in-memory rendono questo linguaggio adatto a diversi settori. Spark si rivela la scelta giusta soprattutto per elaborare, interrogare o calcolare grandi e complesse quantità di dati nelle applicazioni Big Data delle grandi aziende. Grazie alla sua velocità elevata, alla scalabilità e alla flessibilità, offre infatti una performance elevata. Per questo motivo Spark viene usato molto per la pubblicità digitale e nell’e-commerce, per la valutazione dei dati finanziari o per i modelli di investimento nelle società finanziarie, nonché per le simulazioni, l’intelligenza artificiale e la previsione dei trend.

Spark trova impiego soprattutto in questi contesti:

- Elaborare, integrare e raccogliere grandi quantità di dati da diverse fonti e applicazioni.

- Interrogazione e analisi interattiva di Big Data.

- Analisi di streaming di dati in tempo reale

- Apprendimento automatico e intelligenza artificiale

- Processi ETL di grandi dimensioni

Approfitta di server dedicati con processori Intel o AMD in Europa senza dover gestire un reparto IT all’interno della tua azienda: prova i server online di IONOS.

Componenti e librerie importanti dell’architettura Spark

I principali elementi dell’architettura Spark sono:

Spark Core

In quanto fondamento dell’intero sistema Spark, Spark Core mette a disposizione le funzioni essenziali di Spark e gestisce la distribuzione delle attività, l’astrazione dei dati, la pianificazione della distribuzione e i processi di input e output. Spark Core usa RDD distribuiti su più cluster di server e computer come struttura dati. Inoltre, rappresenta la base per Spark SQL, le diverse librerie, Spark Streaming e tutti gli altri singoli componenti.

Spark SQL

Spark SQL è una libreria particolarmente adatta per utilizzare gli RDD come interrogazioni SQL. A questo scopo Spark SQL genera tabelle DataFrame temporanee. Con Spark SQL è possibile accedere a diverse fonti di dati lavorando con dati strutturati ed eseguendo interrogazioni tramite SQL e altre API DataFrame. Inoltre, consente l’integrazione del linguaggio di database HiveQL per accedere a un data warehouse gestito con Hive.

Spark Streaming

Grazie a questa eccellente funzionalità API è possibile utilizzare funzioni di streaming dei dati altamente scalabili e resistenti agli errori, nonché elaborare o visualizzare flussi di dati continui in tempo reale. Partendo dai flussi di dati, Spark genera singoli pacchetti per azioni di dati. Anche allenando specifici modelli di apprendimento automatico è quindi possibile usare flussi di dati.

MLIB Machine Learning Library

Questa libreria scalabile di Spark fornisce un codice di apprendimento automatico per l’uso di processi statistici avanzati in cluster di server o per lo sviluppo di applicazioni di analisi. Include comuni algoritmi di apprendimento come clustering, regressione, classificazione e raccomandazione, servizi di flusso di lavoro, valutazione dei modelli, statistiche lineari distribuite e algebra o trasformazioni di caratteristiche. Con MLlib è possibile scalare e semplificare l’apprendimento automatico in modo efficace.

GraphX

La API Spark GraphX serve per il calcolo parallelo dei grafi e unisce ETL, elaborazione di grafici interattiva e analisi esplorative.

Com’è nato Apache Spark?

Apache Spark è stato sviluppato nel 2009 presso l’Università della California, a Berkeley, in quanto parte di AMPlabs. Dal 2010 Spark è disponibile gratuitamente al pubblico grazie a una licenza open source. Nel 2013 la Apache Software Foundation ha rilevato il progetto continuando a ottimizzarlo. Grazie alla popolarità e al potenziale del framework per i Big Data, a febbraio 2014 l’ASF ha dichiarato Spark un “progetto di primo livello”. La versione 1.0 di Spark è stata rilasciata a maggio 2014. Attualmente (dati aggiornati ad agosto 2023) Spark è disponibile nella versione 3.4.1.

L’obiettivo di Spark è accelerare le richieste e i compiti nei sistemi Hadoop. Usando Spark Core come base, questo motore consente l’invio distribuito di compiti, funzionalità di input-output e l’elaborazione in-memory, superando quindi nettamente MapReduce, fino ad allora molto usato nel framework Hadoop.

Quali vantaggi offre Apache Spark?

Spark offre i seguenti vantaggi per l’interrogazione ed elaborazione rapide di gradi quantità di dati:

- Velocità: i carichi di lavoro possono essere elaborati ed eseguiti con una rapidità 100 volte superiore rispetto a MapReduce di Hadoop. Ulteriori vantaggi in termini di performance derivano dal supporto per l’elaborazione di batch e dati di streaming, grafi orientati aciclici, un motore fisico di esecuzione e l’ottimizzazione delle query.

- Scalabilità: grazie all’elaborazione in-memory dei dati distribuiti su cluster, Spark offre una scalabilità flessibile delle risorse.

- Coerenza: Spark è un framework completo per i Big Data che combina diverse funzioni e librerie in un’unica applicazione. Queste includono query SQL, DataFrame, Spark Streaming, MLlib per l’apprendimento automatico e GraphX per l’elaborazione dei grafi. Da non dimenticare infine l’integrazione con HiveQL.

- Usabilità: grazie alle semplici interfacce API per una varietà di fonti di dati nonché agli oltre 80 operatori comuni per lo sviluppo di software, Spark riunisce numerose possibilità di applicazione in un solo framework. Particolarmente pratico è anche l’uso interattivo di shell per Scala, Python, R o SQL per poter scrivere servizi.

- Framework open source: grazie al suo approccio open source, Spark gode di una comunità globale e attiva di esperti che si occupano del suo sviluppo continuo, risolvendo falle di sicurezza e garantendo una rapida innovazione.

- Aumento dell’efficienza e riduzione dei costi: poiché Spark può essere utilizzato anche senza server high-end con strutture fisiche, la piattaforma offre funzionalità in grado di ridurre i costi e di aumentare le prestazioni per le analisi dei Big Data, in particolare per gli algoritmi di apprendimento automatico e per processi di dati paralleli.

Quali svantaggi presenta Apache Spark?

Nonostante tutti i punti di forza elencati in precedenza, Spark presenta anche alcuni svantaggi. Il primo e più importante riguarda il fatto che Spark non dispone di un motore di memoria integrato e si affida quindi a numerosi componenti distribuiti. L’elaborazione in-memory richiede inoltre molta RAM, il che può influire sulle prestazioni qualora le risorse non siano sufficienti. Inoltre, l’uso di Spark richiede una familiarizzazione più lunga per poter comprendere i processi alla base della configurazione di un server web Apache o di altre strutture.