Token IA: definizione, funzionamento e calcolo

I token IA rappresentano la più piccola unità linguistica che serve ai modelli di IA per elaborare e interpretare il testo. Con la tokenizzazione IA, il linguaggio viene scomposto in questi blocchi, che costituiscono la base per l’analisi e la generazione di testi. Gli strumenti come OpenAI Tokenizer consentono di determinare i token di un testo in modo semplice e rapido.

Definizione: cosa sono i token IA?

I token IA (token di intelligenza artificiale) costituiscono la più piccola unità di dati dei modelli di IA come ChatGPT, LLama2 e Copilot. Sono l’elemento più importante per l’elaborazione, l’interpretazione e la generazione di testo, perché solo scomponendo un testo in token l’intelligenza artificiale può comprendere il linguaggio e fornire risposte adatte alle richieste degli utenti. I token IA possono quindi rappresentare sia singole parole o parti di parole, sia segni di interpunzione ed emoji.

Il numero di token IA di cui si compone un testo dipende da diversi fattori. Oltre alla lunghezza del testo, sono rilevanti ad esempio anche la lingua e il modello di IA utilizzati. Se utilizzi un accesso alle API come l’API di ChatGPT , il numero di token determina anche i costi da sostenere. Nella maggior parte dei casi, le applicazioni di IA calcolano i token IA consumati singolarmente.

- Siti web in tempo record

- Soluzioni IA per il tuo business

- Risparmio di tempo e risultati eccellenti

Come funziona la tokenizzazione IA?

Il processo con cui un modello di IA converte il testo in token è chiamato “tokenizzazione IA”. È necessario perché i modelli linguistici di grandi dimensioni hanno bisogno di linguaggio naturale in una forma analizzabile dalle macchine. La tokenizzazione costituisce pertanto la base per l’interpretazione del testo, il riconoscimento di modelli e la generazione di risposte. Senza questo processo di conversione l’intelligenza artificiale non sarebbe in grado di rilevare i contesti semantici e relazionali. La conversione del testo in token è costituita da più passaggi e si svolge come segue:

- Normalizzazione: in una prima fase, il modello di IA converte il testo in una forma standardizzata, riducendo la complessità e la varianza. Con la normalizzazione, tutto il testo viene trasformato in lettere minuscole. Inoltre, il modello rimuove i caratteri speciali e talvolta riduce le parole alle forme base.

- Scomposizione del testo in token: nel passo successivo, l’IA scompone il testo in token, ossia in unità linguistiche più piccole. L’entità della scomposizione dipende dalla complessità e dall’addestramento del modello. La frase “L’IA rivoluziona il marketing” presenta un numero differente di token a seconda delle versioni GPT. Ad esempio, in GPT-4 risulta costituita da quattro token e in GPT-4o da cinque.

- Assegnazione di valori numerici: successivamente il modello di IA assegna a ciascun token IA un valore numerico, denominato ID del token. Gli ID sono in un certo senso il vocabolario dell’intelligenza artificiale, che contiene tutti i token noti al modello.

- Elaborazione del token IA: il modello linguistico analizza la relazione tra i token per rilevare modelli e fornire previsioni o risposte, che vengono generate in base alla probabilità. Il modello di IA osserva le informazioni sul contesto e determina i token IA successivi sempre in base a quelli precedenti.

- Conformità al GDPR e hosting sicuro in Europa

- Potenti modelli basati sull'intelligenza artificiale

- Assenza di vendor lock-in grazie all'open source

Come si calcolano i token di un testo?

Possiamo comprendere in che modo i token sono calcolati dall’IA mediante i cosiddetti tokenizer, che scompongono i testi nelle unità di elaborazione più piccole. Lavorano con algoritmi specifici che si basano sui dati di addestramento e sull’architettura del modello di IA. Oltre a indicare il numero di token, questi strumenti possono anche fornire informazioni dettagliate su ogni singolo token, ad esempio il relativo ID numerico. In questo modo non solo è possibile calcolare meglio i costi, ma si ottimizza anche l’efficienza dei testi nella comunicazione con i modelli di IA.

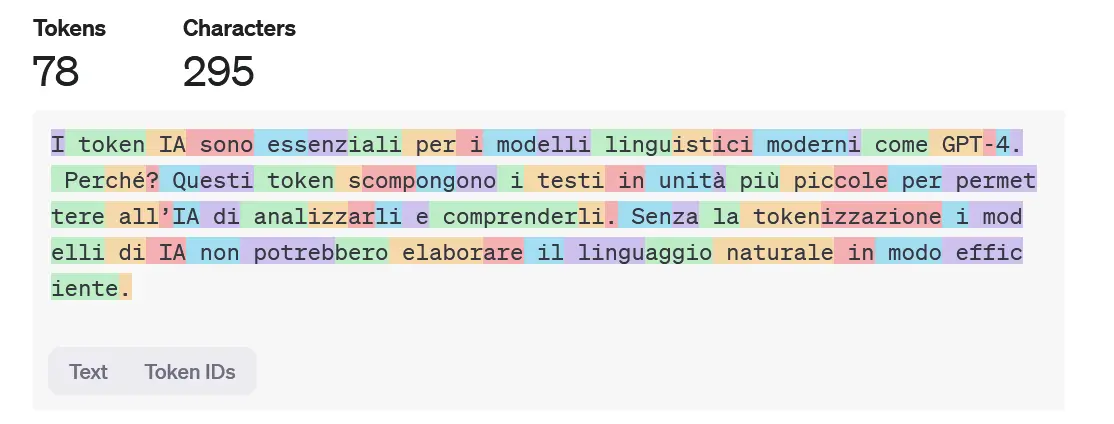

Un esempio di tokenizer ad accesso libero è OpenAI Tokenizer, progettato per gli attuali modelli di ChatGPT. Dopo aver copiato o digitato il testo desiderato nel campo di immissione, l’applicazione ti presenta i singoli token IA evidenziando le unità con colori.

La lunghezza massima del testo dipende sempre dal limite di token del relativo modello. Ad esempio, GPT-4 può elaborare fino a 32.768 token per richiesta.

Token IA e tokenizzazione: esempio pratico

Di seguito un breve testo di esempio per comprendere meglio la tokenizzazione IA.

I token IA sono essenziali per i modelli linguistici moderni come GPT-4. Perché? Questi token scompongono i testi in unità più piccole per permettere all’IA di analizzarli e comprenderli. Senza la tokenizzazione i modelli di IA non potrebbero elaborare il linguaggio naturale in modo efficiente.

Il modello GPT-4o suddivide questo testo, composto da 295 caratteri, in 78 token, rappresentanti nella maniera seguente: