Che cos’è un crawler? I responsabili dell’ottimizzazione di Internet

I crawler sono il motivo per cui motori di ricerca come Google, Bing, Yahoo e DuckDuckGo possono fornire risultati di ricerca sempre aggiornati e nuovi. Come ragni, questi bot migrano attraverso la rete, raccolgono informazioni e creano indici. Ma in quali contesti si usano i web crawler e che tipi di spider esistono sul World Wide Web?

Cosa sono i crawler?

I crawler sono bot che cercano dati su Internet. Analizzano contenuti e creano database e indici con le informazioni raccolte per migliorare le prestazioni dei motori di ricerca. Inoltre, raccolgono dati di contatto e di profilo per scopi di marketing.

Questi bot sono noti anche come spider perché attraversano la rete con tutte le sue diramazioni in cerca di informazioni senza alcuna difficoltà. Talvolta vengono anche chiamati bot e web crawler. Il primo crawler è stato il World Wide Web Wanderer (in breve WWW Wanderer) che era basato sul linguaggio di programmazione PERL. A partire dal 1993, il WWW Wanderer misurava la crescita di Internet, allora ancora ai suoi esordi, e raccoglieva i dati nel primo indice Internet chiamato Wandex.

Nel 1994, dopo il WWW Wanderer, è stato pubblicato il primo browser chiamato Webcrawler, che oggi è il motore di ricerca più vecchio ancora esistente. I crawler consentono ai motori di ricerca di mantenere i propri database aggiungendo nuovi contenuti, aggiornando quelli esistenti ed eliminando quelli obsoleti dall’indice, tutto in modo automatico.

I crawler sono di particolare importanza per l’ottimizzazione per i motori di ricerca (SEO). Per le aziende è, quindi, essenziale familiarizzare con le diverse tipologie e le funzioni dei web crawler per offrire contenuti online ottimizzati in termini di SEO.

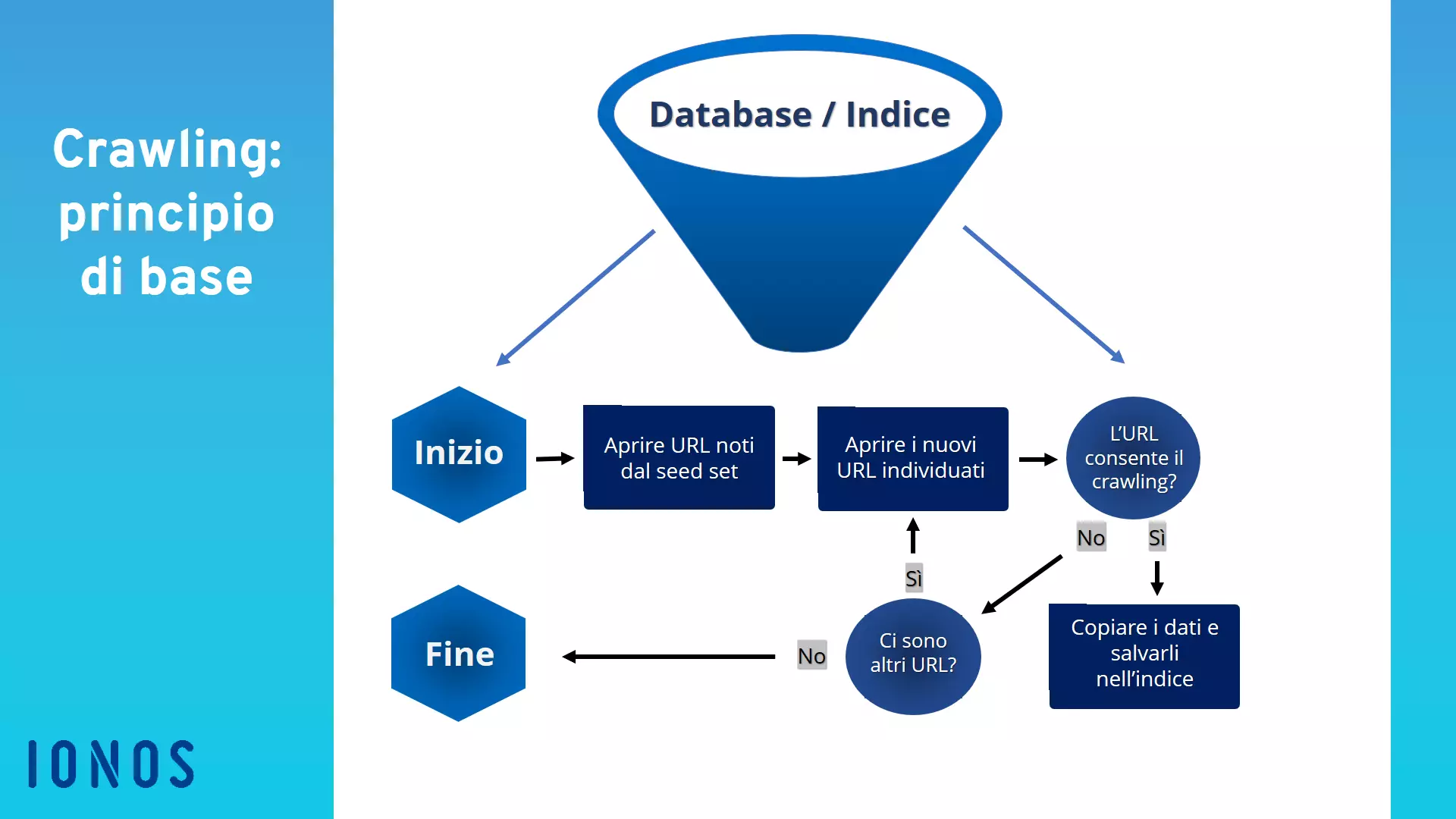

Come funziona un crawler?

Proprio come i social bot e i chatbot, anche i crawler sono costituiti da un codice di algoritmi e script che fornisce compiti e comandi chiari. Il crawler ripete le funzioni specificate nel codice in modo indipendente e continuo.

I crawler si muovono nel web attraverso i collegamenti ipertestuali di siti web esistenti. Inoltre valutano parole chiave e hashtag, indicizzano i contenuti e gli URL di ogni sito web, copiano pagine web e aprono tutti o solo una selezione degli URL trovati per analizzare nuovi siti web. I crawler controllano anche l’attualità di link e codici HTML.

Utilizzando speciali strumenti di analisi web, i web crawler possono valutare informazioni come le visualizzazioni di pagina e i link e raccogliere o confrontare in modo mirato i dati (ad esempio per portali di confronto) nell’ambito del data mining.

Tipi di crawler

Esistono diversi tipi di web crawler che differiscono per obiettivo e portata.

Crawler di motori di ricerca

Il tipo di web crawler più datato e comune sono i bot di ricerca di Google o di altri motori di ricerca come Yahoo, Bing o DuckDuckGo. Questi bot visualizzano, raccolgono e indicizzano i contenuti web per ottimizzare la portata e il database dei motori di ricerca. I web crawler più famosi sono:

- GoogleBot (Google)

- Bingbot (Bing)

- Slurpbot (Yahoo)

- DuckDuckBot (DuckDuckGo)

- Baiduspider (Baidu)

- Yandex Bot (Yandex)

- Sogou Spider (Sogou)

- Exabot (Exalead)

- Facebot (Facebook)

- Alexa Crawler (Amazon)

Crawler per siti web personali

Questi piccoli crawler hanno un funzionamento piuttosto semplice e possono essere utilizzati da singole aziende per eseguire compiti specifici. Essi monitorano, ad esempio, la frequenza d’uso di determinati termini di ricerca o l’accessibilità di specifici URL.

Crawler commerciali per siti web

I crawler commerciali sono software più complessi venduti da aziende specializzate. Questi spider offrono prestazioni e funzionalità maggiori e consentono alle aziende di risparmiare il tempo e le risorse che lo sviluppo individuale di un crawler richiederebbero.

Crawler di siti web nel cloud

Esistono anche crawler di siti web che memorizzano i dati non su server locali, ma in un cloud e che sono di solito distribuiti commercialmente come servizio da società di software. L’indipendenza da computer locali consente di utilizzare gli strumenti di analisi e i database mediante accesso da qualsiasi dispositivo e l’uso è facilmente scalabile.

Crawler desktop di siti web

Un’altra possibilità è eseguire piccoli web crawler sul proprio computer o laptop. Questi crawler sono in genere molto limitati nell’uso ed economici e possono valutare solo piccole quantità di dati e siti web.

Funzionamento pratico dei crawler

La procedura concreta di un web crawler consiste in diversi passaggi:

- Frontiera di indicizzazione: in una struttura di dati denominata crawl frontier, frontiera di indicizzazione in italiano, i motori di ricerca determinano se i crawler devono esplorare nuovi URL tramite i siti web indicizzati noti e i collegamenti specificati nelle sitemap o se indicizzare solo siti web e contenuti specifici.

- Seed set: i crawler ricevono dal motore di ricerca o dal committente un cosiddetto seed set o set di semi. Questo set di semi consiste in un elenco di indirizzi web e URL conosciuti o da visitare. Il set si basa su indici, database e sitemap precedenti. I crawler esplorano il set fino a raggiungere loop o link inattivi.

- Integrazione dell’indice: l’analisi dei semi consente ai crawler di valutare nuovi contenuti web e di aggiungerli all’indice. Contenuti obsoleti vengono aggiornati o eliminati.

- Frequenza di scansione: sebbene i crawler esplorino il web continuamente, i programmatori possono determinare con quale frequenza devono visitare e valutare gli URL. A tale scopo, analizzano le prestazioni delle pagine, la frequenza degli aggiornamenti e il traffico di dati. Sulla base di queste informazioni, i programmatori determinano la frequenza di indicizzazione.

- Gestione dell’indicizzazione: gli amministratori di siti web hanno l’opzione di impedire a determinati crawler di visitare il proprio sito web tramite i cosiddetti protocolli robots.txt o i tag HTML nofollow. Quando i crawler accedono a un URL gli viene richiesto di evitare il sito web o di valutare i dati solo in misura limitata.

Quali vantaggi offre un crawler?

Conveniente ed efficace: i web crawler si occupano di attività di analisi dispendiose in termini di tempo e costi e possono scansionare, analizzare e indicizzare i contenuti web più velocemente e in modo più economico e completo rispetto agli esseri umani.

Facile da usare, ampia portata: l’implementazione dei web crawler è facile e veloce e garantisce una raccolta e un’analisi dei dati completa e continua.

Miglioramento della reputazione online: i crawler ottimizzano il vostro marketing online espandendo e focalizzando lo spettro di clienti. La reputazione online di un’azienda può anche beneficiare della cattura di modelli di comunicazione sui social media grazie ai crawler.

Pubblicità mirata: il data mining e la pubblicità mirata permettono di rivolgersi a gruppi di clienti specifici. I siti web con una frequenza di scansione più elevata sono elencati più in alto nei motori di ricerca e ottengono più visualizzazioni.

Valutazione dei dati di clienti e di quelli aziendali: i crawler consentono alle aziende di valutare, analizzare e utilizzare i dati dei clienti e delle aziende disponibili online per ottimizzare la propria strategia di marketing e imprenditoriale.

Ottimizzazione SEO: valutando termini di ricerca e parole chiave, è possibile definire frasi chiave, limitare la concorrenza e aumentare le visualizzazioni delle pagine.

Altri possibili contesti d’uso sono:

- monitoraggio continuo dei sistemi per identificare punti deboli

- archiviazione di siti web datati

- confronto di siti web aggiornati con le vecchie versioni

- ricerca e rimozione di collegamenti inattivi

- valutazione del volume di ricerca delle keyword

- rilevamento di errori ortografici e altri contenuti non corretti

Come aumentare la frequenza di scansione di un sito web?

Se volete che il vostro sito web appaia tra i primi risultati nei motori di ricerca e venga regolarmente visitato dai web crawler, dovreste rendere il più facile possibile per i bot trovare il vostro sito. Chi ha un’alta frequenza di scansione ottiene una priorità più elevata nei motori di ricerca. Per facilitare l’individuazione di un sito web da parte dei crawler, sono fondamentali i seguenti fattori:

- Il sito web include diversi link e viene citato tramite collegamento su altri siti web. In questo modo, i crawler trovano il sito web non solo tramite link, ma lo considerano anche come un nodo che conduce altrove e non solo come una strada a senso unico.

- Il contenuto del sito web è sempre aggiornato. Ciò vale per il contenuto, i link e il codice HTML.

- L’accessibilità del server è garantita.

- Il tempo di caricamento del sito web è buono.

- Non ci sono link e contenuti duplicati o ridondanti.

- Sitemap, robots.txt e HTTP Response Header forniscono al crawler già informazioni importanti sul sito web.

Web crawler e scraper: qual è la differenza?

Anche se vengono spesso equiparati, web crawler e scraper non appartengono allo stesso tipo di bot. Mentre i web crawler cercano, valutano e raccolgono i contenuti web in indici, gli scraper hanno principalmente il compito di estrarre i dati dai siti web mediante il web scraping.

Sebbene un crawler e uno scraper abbiano degli aspetti in comune e anche i crawler utilizzino spesso il web scraping copiando e salvando contenuti web, le loro funzioni principali sono il recupero di URL, l’analisi dei contenuti e l’integrazione dell’indice con nuovi link e URL.

Gli scraper, invece, hanno principalmente la funzione di visitare determinati URL, estrarre dati specifici dai siti web e memorizzarli in database per un uso successivo.